Nvidia의 차세대 블랙웰 플랫폼이 2025년 초에 Google Cloud로 출시될 예정

올해 Las Vegas에서 열리는 Google Cloud Next는 새로운 인스턴스 유형과 가속기가 Google Cloud 플랫폼에 도입되는 시기입니다. 구글이나 Nvidia에서 제작된 AI 가속기에 관한 올해의 발표 중 대부분은 새로운 사용자 정의 Arm 기반 Axion 칩과 관련이 있습니다.

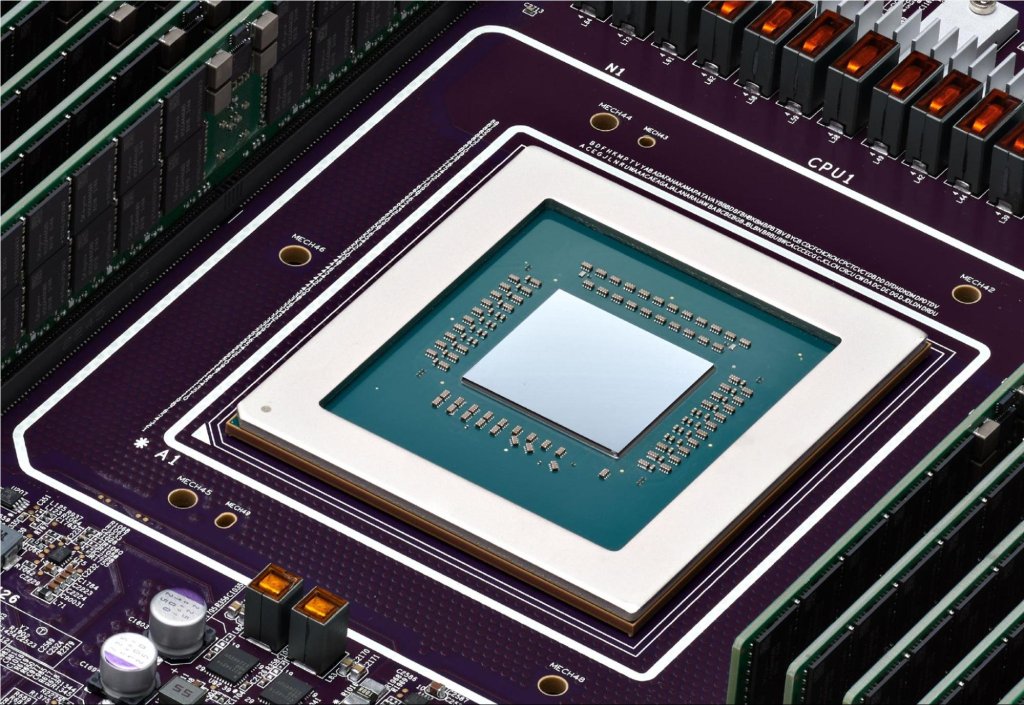

몇 주 전에 Nvidia가 블랙웰 플랫폼을 발표했지만, 구글이 이러한 기기를 곧 제공할 것으로 기대하지 마십시오. 고성능 Nvidia HGX B200 및 대언어 모델 (LLM) 훈련용 GB200 NBL72을 지원하는 서비스는 2025년 초에 제공될 예정입니다. 구글 발표에서 흥미로운 사실 한 가지는 GB200 서버가 액체 냉각된다는 것입니다.

이는 조금 이른 발표인 것 같지만, Nvidia는 블랙웰 칩이 올해 말까지 공개되지 않을 것이라고 말했습니다.

블랙웰 이전

오늘날 대량의 LLM을 훈련시키기 위해 더 많은 성능이 필요한 개발자를 위해 구글은 또한 Nvidia와 함께 개발한 A3 Mega 인스턴스를 발표했습니다. 이 인스턴스는 업계 표준 H100 GPU를 기반으로 하지만, GPU 당 대역폭을 최대 2배까지 제공할 수 있는 새로운 네트워킹 시스템을 결합하고 있습니다.

다른 새로운 A3 인스턴스인 A3 confidential은 구글이 “고객이 훈련과 추론 과정 중 민감한 데이터 및 AI 작업의 기밀성과 무결성을 더 잘 보호할 수 있게 하는” 것으로 설명했습니다. 회사는 데이터 사용 중에 암호화하는 기밀 컴퓨팅 서비스를 오래 전부터 제공해왔으며, 여기서도 암호 컴퓨팅을 활성화하면, 기밀 컴퓨팅이 데이터 전송을 Intel CPU와 Nvidia H100 GPU간에 PCIe를 통해 확보된 방식으로 암호화합니다. 코드 변경이 필요하지 않다고 구글은 말합니다.

구글의 자체 칩에 대해, 회사는 화요일에 자체 개발한 최고 속도의 Cloud TPU v5p 프로세서를 일반 공급으로 출시했습니다. 이 칩은 부동 소수점 연산을 초당 2배 향상시키고 메모리 대역폭 속도는 3배 향상시킨 것을 특징으로 합니다.

모든 이러한 빠른 칩들은 그들과 발맞춰 갈 수 있는 기본 아키텍처가 필요합니다. 그래서 새로운 칩 외에도, 구글은 화요일에 새로운 AI 최적화 스토리지 옵션을 발표했습니다. Hyperdisk ML은 현재 미리보기 단계에 있으며 최대 3.7배까지 모델 로드 시간을 개선할 수 있는 회사의 차세대 블록 스토리지 서비스입니다.

Google Cloud은 또한 Intel의 4세대 및 5세대 Xeon 프로세서를 기반으로 한 여러 전통적인 인스턴스를 출시하고 있습니다. 예를 들어, 새로운 범용 C4 및 N4 인스턴스는 다섯 번째 세대 Emerald Rapids Xeons를 특징으로 하며, C4는 성능에 중점을 둔 반면 N4은 가격에 중점을 두고 있습니다. 새로운 C4 인스턴스는 현재 비공개 미리보기 단계에 있으며, N4 기기들은 오늘부터 일반적으로 이용 가능합니다.

또 다른 새로운 기기로, 아직 미리보기 단계에 있는 C3 베어 메탈 머신, 오래된 네 번째 세대 Intel Xeon 프로세서를 기반으로 한 X4 메모리 최적화 베어 메탈 인스턴스 및 가장 뛰어난 IOPS를 제공하기로 약속하고 있는 구글 클라우드의 최초의 저장소 최적화 가상 머신인 Z3가 있습니다.

Nvidia가 GTC에서 발표한 주요 내용들